Propozycja budowy zaplecza dla przedsiębiorstwa z branży meblarskiej. Aktualna strona stanowi wsparcie dla handlowo-wizerunkowe firmy Mebelskol, działającej na rynku lokalnym firmy, kompleksowo wyposażającej szkoły i biura w sprzęt i narzędzia.

Historia i status aktualny strony www Firmy

Firma istnieje od 1993, kontynuując tradycję ogólnopolskiej sieci zaopatrzenia szkół Mebelskol, która to sieć stanowiła monopol na tym rynku przed rokiem 1989. Dzięki długoletniej współpracy ze szkołami ma ugruntowaną markę. Z powodu łatwiejszego dostępu do sieci, większej świadomości istnienia konkurencji przez szkoły i sporej rosnącej konkurencji Firma musiała radykalnie ciąć koszty, przenosząc działalność niektórych działów do zewnętrznych podmiotów. Zadaniem powstałej w 1998 roku strony WWW, było przede wszystkim ułatwienie dotarcia potencjalnym klientom do oferty Firmy, a dotychczasowym klientom – zorientowanie się w nowościach, bez konieczności wykonywania połączeń telefonicznych. Do roku 2006 strona internetowa stanowiła jedynie wizytówkę firmy w Internecie, wraz z informacją o podstawowych obszarach działania Firmy i kilkudziesięcioma produktami. Całość strony stworzona była niechlujnie w zakresie kodu (m.in. blokowanie spiderów) jak i grafiki (całkowicie nieużyteczne i niespójne z identyfikacją graficzną Firmy kolory i prezentacja produktu). W roku 2006 została przygotowana i strona WWW wraz z 2000 produktów, która w 2009r. została przebudowana, zaktualizowana pod kątem wyszukiwarek i użyteczności, a jej start przewidziany jest na 1 lutego 2010r.

Cel, potrzeby i sposób budowy zaplecza strony www

Zarząd Firmy zauważył wzrost sprzedaży dzięki stronie WWW, która w 2008 roku stanowiła już 40% całości obrotu, pomimo istniejącej grupy tzw. hard-userów, silnie związanych z Firmą w świecie off-line. Była to spora część przychodów zwłaszcza, że do tej pory aspekt udziału znaczenia strony WWW w dochodach był raczej marginalizowany. W 2009 roku została wydana decyzja o podjęciu działań zmierzających do rozszerzenia zaplecza linków, pozycjonowania strony na zwiększenia rozpoznawalności marki.

Należało wypracować z Firmą cele, które ma spełniać witryna (konwersje, czyli kontakt z oddziałem w celu zamówienia produktów), a także ogólną strategię pozycjonowania, uwzględniającą określenie grupy docelowej, listę działań do podjęcia przy tworzeniu zaplecza i pozycjonowania strony. Stworzenie takiej strategii nie było wcale proste – klienci offline byli dobrze znani i byli to stali klienci; w odróżnieniu do nowej witryny klientów online należało zidentyfikować, sparametryzować i opisać psychograficznie. Założono, iż grupa docelowa to dyrektorzy techniczno-administracyjni placówek publicznych, edukacyjnych, kulturowych i oświatowych, biur, a także osoby odpowiedzialne za zamówienia publiczne. Wzięto pod uwagę osoby z miast powyżej 10000 mieszkańców, które wcale lub sporadycznie dokonują zakupów online. Dla określonej grupy docelowej została stworzona strategia działań SEM, których przeprowadzenie warunkowało wzrost pozycji strony docelowej w SERP, co miałoby przełożenie na konwersje – w tym przypadku skontaktowanie się z centralą firmy i dokonanie zamówienia:

- Wybrano hosting zlokalizowany w Polsce (target to Polacy, więc ping i szybkość ładowania strony jest tu istotna), dokonano wyboru silnika pod przyszłą stronę pod kątem bezpieczeństwa, możliwości rozwoju i optymalizacji, elastyczności modyfikacji i częstotliwości aktualizacji – wybór padł na darmowy, charakteryzujący się bardzo dużą ilością wdrożeń i rozszerzeń – system WordPress

- Dokonano monitoringu konkurencji – działań SEM, public relations, doboru słów kluczowych i działań on-site. Na tej podstawie została przygotowana strategia podobnych działań, zmierzających do przewyższenia ilości odwiedzin strony docelowej w porównaniu ze stronami konkurencji w okresie 12 miesięcy.

- Dokonano analizy słów kluczowych – skupiono się na optymalizacji przyszłego serwisu pod kątem strategii Long Tail – głównym źródłem odwiedzin strony z wyszukiwarek wybrano hasła 2-5 wyrazowe. Do budowy słów użyto narzędzi (m.in. Google External Tool, SEOmoz tools, Keyword Elite). Do wygenerowanej listy słów kluczowych stworzono zoptymalizowane strony – landing pages (pod kątem możliwości nawiązania kontaktu) – z odpowiednią ilością zagęszczenia i zaakcentowania (pogrubienie, kursywa) słów kluczowych, zoptymalizowaną konstrukcją tytułu, meta-tagów, grafik, zdjęć i formatowaniem treści (użycie znaczników html). Long tail dotyczył pozyskania ruchu z zapytań w wyszukiwarkach o konkretne produkty lub ich funkcjonalności – w tym miejscu klient wie czego potrzebuje, więc pozyskanie takiego użytkownika bliskie jest 100% prawdopodobieństwu, że ten dokona konwersji.

- W oparciu o wygenerowaną listę słów kluczowych została stworzona mapa strony WWW, której podstrony rozbudowano o kolejne podstrony zależne, docelowo przejmujące ruch z długich zapytań wyszukiwania (long tail – np. „nauczanie zintegrowane pomoce dydaktyczne”, czy „anatomia człowieka modele narządy wewnętrzne”)

- Dla uzyskania wejść z wyszukiwarek na zapytania na krótkie – 1-2 wyrazowe zapytania (short tail / head) wybrano kombinacje haseł związanych z marką, lokalizacją i kategorią towaru (np. „globusy”, „meble Warszawa”, „wyposażenie szkół”, „krzesła Nowystyl”)

- Zoptymalizowano kod pod kątem szybkości ładowania, łatwości penetracji przez spidery i łatwości indeksowania przez indexer. Niektóre strony (formularze, instrukcje ogólne, strony tematycznie nie związane z treścią odpowiedzialną za konwersje) zostały wyłączone z indeksacji, a odwołania do stron niepożądanych zostały oznaczone znacznikiem rel=”nofollow”.

- Stworzono mapy stron – nawigacyjną dla użytkowników oraz dla spiderów, która została podłączona do systemów indeksujących i społecznościowych (Friendfeed, Google Webmaster Tools, Twitter, Blip), przygotowano plik robots.txt

- Przygotowano strony błędów oraz miejsca nawigacji i zoptymalizowano je pod kątem użyteczności

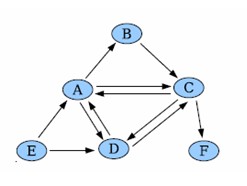

- Zrealizowano organizację i strukturę linkowania wewnętrznego i na tej podstawie rozpoczęto realizację budowy zaplecza linków zewnętrznych

Podstawowym zadaniem było zwiększenie zasięgu w dotarciu do nowych klientów na terenie całej Polski, w zakresie krytycznych obszarów działalności Firmy. Do realizacji tego celu zostały podjęte następujące działania:

Działania online

Działania związane z optymalizacją witryny (w tym naturalne pozyskiwanie zaplecza)

- Stworzenie nowej strony, opartej na silniku WordPress (darmowy, łatwa instalacja, obsługa, elastyczność, bezpieczeństwo, możliwości aktualizacji i rozwoju, wsparcie tysięcy programistów i posiada wersję polską)

- Optymalizacja kodu pod kątem SEO (odpowiednie tytuły, meta tagi , opisy grafik i linków, przyjazne linki, nagłówki h1-h6, optymalizowanie kodu wg wskazówek Google Webmaster Tools, szybkość ładowania strony, optymalizacja struktury treści) z systemem wewnętrznego linkowania

- Utworzenie kilku możliwości nawigacji (menu, okruszki/breadcrumb, mapa strony, tagi, wyniki wyszukiwarki wewnętrznej, podpowiedzi stron podobnych (produkty powiązane), tworzenie stron ulubionych

- Optymalizacja użyteczności witryny (typografia, widoczność linków, modyfikacja arkuszy stylów, spójność identyfikacji wizualnej, czytelność grafik i treści, światło wokół modułów, intuicyjne nawigowanie użytkownika do miejsc, których poszukuje)

- Tworzenie treści czytelnych dla ludzi i spiderów – pisanie prostym, zrozumiałym językiem z odpowiednim nagromadzeniem słów kluczowych na stronie, używanie znaczników html do akcentowania najważniejszych treści, tworzenie tekstów reklamowych

- Tworzenie materiałów atrakcyjnych do przekazywania między użytkownikami (atrakcyjne promocje, niestandardowe produkty) i uzyskiwanie odwołań do strony docelowej

Działania zewnętrzne

- Stworzenie sklepów tematycznych, w których nowi i obecni klienci Firmy mogą bezpośrednio zamawiać towary – daje to możliwość odciążenia działu obsługi klienta w procesie zamawiania

- Skierowanie do zarejestrowanych użytkowników cyklicznego mailingu z informacją o promocji, zawierającego kod umożliwiający otrzymanie rabatu na zakupy w sklepie – częstszy kontakt z marką, gratyfikacja użytkowników – istotna dbałość o kontakt z marką

-

Stworzenie podstron ściśle tematycznie związanych z kategorią oferty, stanowiące zaplecze

- strony z ofertą przeznaczoną dla danego regionu typu: meble.warszawa.pl (wsparcie dla wirtualnych biur w różnych miastach z lokalnymi numerami telefonów, które przekierowują rozmowy do centrali Firmy) – stwarza to potencjalną chęć konwersji użytkownika ze względu na stworzeniu wirtualnej bliskości klienta i sprzedawcy (klienci bardziej ufają firmom mającym siedzibę w tym samym mieście lub regionie)

- strony z zawężoną ofertą produktową – wszystkie z różnymi adresami IP, oparte na różnych skryptach, zróżnicowane pod kątem treści, anchorów, miejsc wstawianie linków, optymalizacji kodu strony,

- strony z niszową ofertą dla szkół prywatnych z wyposażeniem sprowadzanym z Norwegii i Wielkiej Brytanii – stworzenie niszy dla produktów o podwyższonej trwałości i estetyce, które są nieco droższe od ich standardowych odpowiedników (wyższe marże)

- inne strony, skupione na najskuteczniejszych wyrażeniach typu long-tail w branży

- katalogi stron (stanowiące przegląd zakresu oferty Firmy, odwołujące się do oferty producentów z branży)

- Podłączenie niektórych ze stron, stanowiących zaplecze do systemów SWL (podłączenie strony głównej jest ryzykowne, a w przypadku nałożenia filtru na SERP strony zaplecza – zmniejsza prawdopodobieństwo nałożenia filtra na stronę docelową)

- Katalogowanie strony w płatnych i bezpłatnych katalogach, branżowych listach firm, webowych spisach firm i innych centrach prezentujących firmy lokalne (wiele osób wciąż korzysta z katalogów zamiast wyszukiwarek, poza tym katalogi stanowią źródło linków do strony docelowej)

- Zlecenie poprzez portal zlecenia.przez.net napisania kilkudziesięciu tekstów z branży – wysyłka tych tekstów do strony typu Presell pages oraz do portali z dziedziny tzw. dziennikarstwa obywatelskiego np. sfora.pl, wiadomosci24.pl (rozpowszechnienie informacji o produktach, na które Firma ma wyłączność i wymuszenie na użytkownikach poszukiwanie tych produktów)

- Kanały RSS strony firmy Mebelskol zostały umieszczone w kilkudziesięciu systemach listujących najnowsze informacje z tych kanałów – np. technorati.com, friendfeed.com (łatwiejsza indeksacja przez wyszukiwarki, zdobywanie kolejnych linków. Kanały RSS są nagminnie wykorzystywane przez spamerów jako źródło treści – linki z RSS są często przenoszone, więc dzięki temu strona docelowa zyskuje jeszcze więcej odwołań – choć niestety niezbyt wartościowych)

- Założenie profili w serwisach społecznościowych, połączonych z systemami wysyłania informacji o nowych wpisach na stronie typu ping.fm (kampanie w serwisach społecznościowych zyskują coraz bardziej na znaczeniu, korzysta z nich wielu klientów Firmy – Firma musi docierać z informacją tam, gdzie są jej klienci)

- Stworzenie kanałów w serwisach wideo z filmami dostarczonymi od producentów oraz własne instrukcje montażu zestawów oraz prezentacje nowinek z branży (odwołania do filmów bardzo często znajdują się pośród SERP, dzięki czemu klienci mogą dowiedzieć się poprzez wideo opatrzone logiem Firmy czegoś więcej o produktach. Obecność form wideo w tym miejscu wspomaga strategię długiego ogona – long tail)

- Stworzenie darmowego ebooka dot. ergonomiczności mebli biurowych, zawierający porady dot. zdrowego trybu użytkowania mebli – tworzenie użytecznych treści jest dobrze postrzegane przez wyszukiwarki, dzięki czemu na znaczeniu zyskuje cała witryna

- Stworzenie kampani PPC w najatrakcyjniejszych pod względem obrotu okresach

- Śledzienie linków zwrotnych konkurencji (przez Yahoo! Site Explorer i dodawanie linka do strony korporacyjnej z tych samych miejsc (konkurencja nie śpi – często korzysta z nowych rozwiązań, które szybko Firma może wdrożyć we własną strategię działań)

- Prezentacja informacji o nowościach dostarczonych od producentów na łamach serwisu korporacyjnego (prezentowanie Firmy jako branżowego źródła informacji o produktach)

- Współpraca z serwisami branżowymi typu meble.pl i publikacja reklam i treści sponsorowanych na łamach tych vortali oraz ich newsletterach

- Pozyskanie linków ze stron producentów, dystrybutorów i innych firm, z którymi współpracuje Mebelskol

- Sprzedaż wizerunkowa w serwisach aukcyjnych

Działania offline

- Darmowe szkolenia dla poddystrybutorów z zakresu nowych trendów i rodzajów sprzętu do wyposażenia szkół i biur z materiałami dostępnymi jedynie na stronie firmowej

- Sponsoring zawodów szkolnych (koszty wynajęcia sali i opłacenia organizacji zawodów) z informacją na banerach dot. strony www

- Wydawnictwo 10 rodzajów katalogów produktów – ogólnego i tematycznych i wysyłka tychże katalogów, w których na każdej stronie po szczegóły widnieje odwołanie do strony WWW

- Udział pracowników Firmy w sympozjach i spotkaniach przedstawicieli branży commerce

- Oklejanie niewielkimi naklejkami z adresem strony i innymi materiałami reklamowymi każdego towaru, który przechodzi przez magazyn Firmy

[1] Baoing Wu, Brian D. Davison – Identifing Link Farm Spam Pages – http://www.cse.lehigh.edu/~brian/pubs/2005/www/link-farm-spam.pdf, 28.11.2009

[2] Rand Fishkin – SEOmoz Whiteboard Friday – How the Link Graph Works – http://vimeo.com/1529679, 28.11.2009